L’Unione Europea è entrata con decisione nell’era della regolamentazione dell’intelligenza artificiale. Con l’AI Act, il primo quadro normativo completo e vincolante al mondo per l’intelligenza artificiale, Bruxelles ha confermato ancora una volta il suo ruolo di trendsetter globale in materia di regolazione. Proprio come era avvenuto in precedenza con il GDPR, l’AI Act sta già influenzando i legislatori ben oltre i confini europei.

Dall’altra parte dell’Atlantico, gli Stati Uniti si trovano in una posizione molto diversa. Pur essendo la sede delle aziende di intelligenza artificiale più potenti al mondo e un centro nevralgico dell’innovazione nel settore, gli U.S.A. non dispongono di una legge federale generale che disciplini l’AI. L’approccio americano risulta invece frammentato: una combinazione di ordini esecutivi, norme settoriali e leggi a livello statale. Tuttavia, con l’entrata in vigore dell’AI Act europeo, emergono segnali che indicano come anche gli Stati Uniti stiano assorbendo elementi del modello europeo, pur cercando di mantenere il loro caratteristico approccio “leggero” alla regolamentazione.

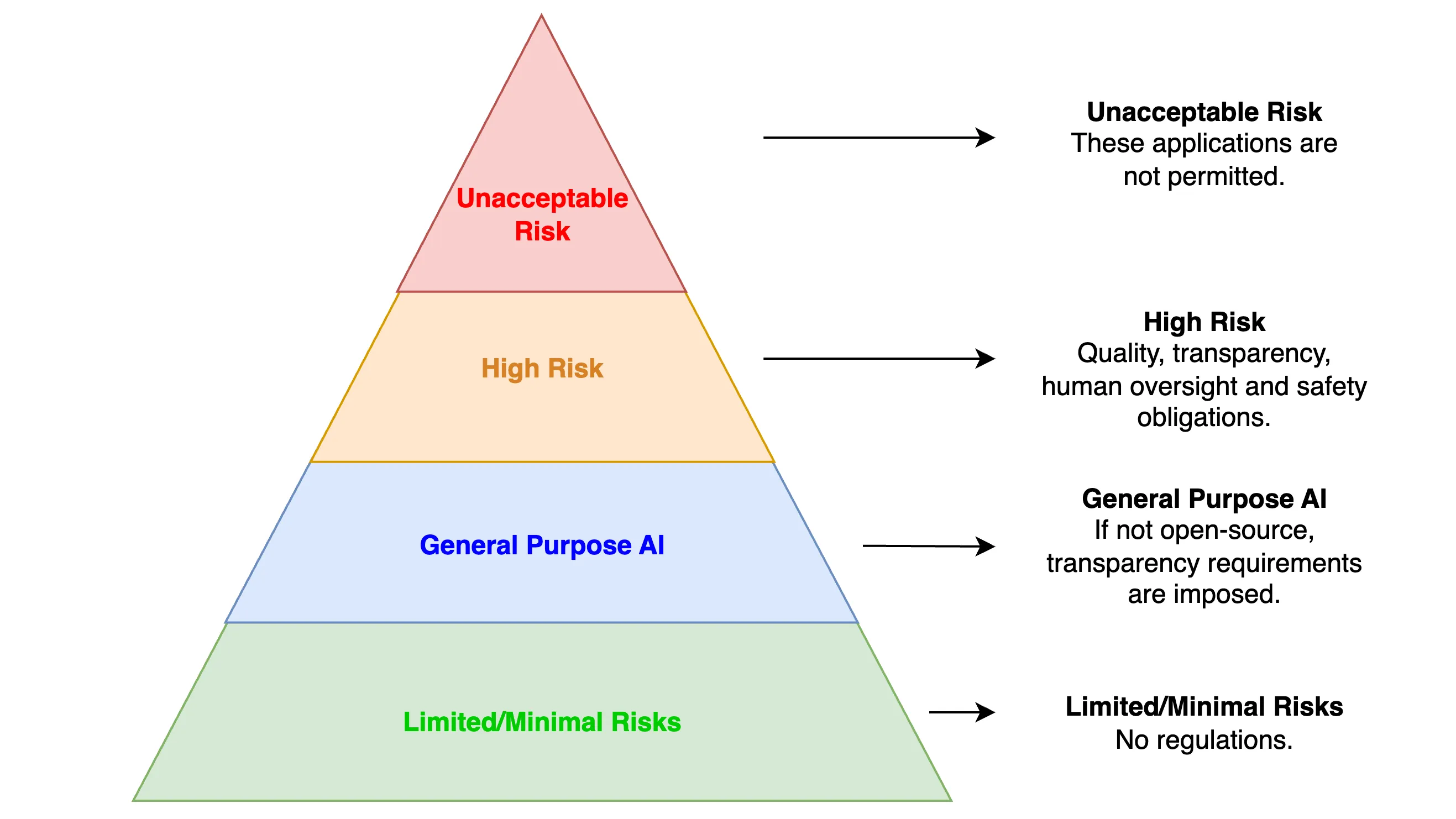

L’AI Act dell’UE, entrato in vigore nell’agosto 2024, crea un quadro normativo basato sul rischio per la governance dell’intelligenza artificiale. I sistemi sono classificati in base al livello di rischio: i sistemi a “rischio inaccettabile” (come il social scoring da parte dei governi) sono vietati del tutto; i sistemi “ad alto rischio” (come l’AI in ambito sanitario o nelle forze dell’ordine) devono rispettare rigorosi requisiti di trasparenza, supervisione umana e test di sicurezza; l’“AI di uso generale”, come i Large Language Models (LLM), deve soddisfare obblighi di trasparenza se non è open-source, mentre le applicazioni a “rischio limitato” e “rischio minimo” sono soggette a obblighi più leggeri.

L’applicazione sarà graduale, con istituzioni dedicate come l’Ufficio AI dell’UE e il Comitato AI che acquisiranno poteri nei prossimi anni. Le sanzioni per la non conformità possono arrivare fino al 7% del fatturato globale, riecheggiando il rigoroso modello di applicazione del GDPR.

In breve, il modello regolatorio dell’UE è completo, centralizzato e precauzionale, concepito per tutelare i diritti fondamentali, garantire trasparenza e gestire i rischi in modo proattivo.

Al contrario, gli Stati Uniti hanno preferito un approccio “light-touch”, orientato prima di tutto all’innovazione, in materia di AI. Finora il governo federale si è astenuto dall’adottare una legislazione di ampio respiro, limitandosi a emanare ordini esecutivi e linee guida delle agenzie per orientare lo sviluppo.

L’Executive Order 14110 del Presidente Biden (novembre 2023) ha sottolineato l’importanza di un’innovazione responsabile dell’AI, assegnando a enti come il National Institute of Standards and Technology (NIST) e il Department of Homeland Security (DHS) il compito di creare standard e quadri di gestione del rischio. La differenza rispetto all’AI Act dell’UE è significativa. Infatti, mentre l’AI Act dell’UE ha fornito un quadro completo con regole su ciò che è consentito o meno, regolamentazioni, sanzioni, ecc., l’EO14110 si è limitato ad avviare il processo di definizione di linee guida e buone pratiche.

Questa posizione è cambiata con l’amministrazione del Presidente Trump, con il lancio dell’AI Action Plan nel 2025 attraverso l’Executive Order 14179. Questo piano ha abrogato gli ordini di Biden e ha posto l’accento sulla deregolamentazione e sulla competitività, segnalando la volontà di Washington di mantenere lo sviluppo dell’AI statunitense agile e dominante a livello globale:

Questo ordine revoca alcune politiche e direttive esistenti sull’AI che costituiscono barriere all’innovazione americana nell’intelligenza artificiale, aprendo la strada affinché gli Stati Uniti possano agire in modo deciso per mantenere la leadership globale nell’AI.

In sintesi, la filosofia degli Stati Uniti resta incentrata sul favorire l’innovazione prima di tutto e lasciare che sia il mercato a svilupparsi, introducendo regolamentazioni solo successivamente per affrontare danni specifici.

A titolo di esempio, sono stati emanati diversi disegni di legge con obiettivi specifici. Il Generative AI Copyright Disclosure Act richiede che le aziende che sviluppano modelli di AI generativa forniscano un elenco dettagliato delle opere protette da copyright utilizzate nel training set (pur senza limitarne l’uso). Il TAKE IT DOWN Act affronta il problema dei deepfake e del revenge porn, cercando di offrire ai cittadini strumenti per affrontare tali situazioni. Infine, il CREATE AI Act ha promosso la democratizzazione dell’accesso all’AI, al fine di incentivare la ricerca e lo sviluppo a beneficio di tutti i cittadini statunitensi.

È da notare che, nel loro complesso, le leggi emanate dal governo U.S.A. sembrano coprire una gamma più ampia di temi legati all’AI rispetto all’AI Act dell’UE, che, pur essendo unificato, ha una sfera di influenza più ristretta. Tuttavia, ciò introduce potenzialmente maggiore confusione e contraddizioni a causa dei diversi linguaggi utilizzati in ogni proposta di legge e della mancanza di coerenza o di una chiara separazione delle sfere di applicazione.

In assenza di una legge federale organica, gli stati U.S.A. hanno colmato il vuoto normativo, e le loro iniziative somigliano sempre più ad aspetti della filosofia europea basata sul rischio e sui diritti. È significativo notare che tutti i 50 Stati hanno approvato leggi relative all’AI nel 2025.

Ad esempio, l’ELVIS Act del Tennessee, in vigore dal luglio 2024, tutela musicisti e artisti dalle imitazioni generate dall’AI, sanzionando l’uso improprio della voce e dell’immagine.

Allo stesso modo, l’AI Policy Act dello Utah impone alle aziende di informare i propri clienti quando interagiscono con un sistema di AI generativa.

Nel maggio 2025, il disegno di legge HB178, approvato in Montana, ha regolamentato alcuni usi dell’AI classificati come “Inaccettabili” e “Ad Alto Rischio”, tracciando un parallelo con l’AI Act dell’UE.

Infine, diversi stati stanno emanando nel 2025 leggi relative all’uso dell’AI in ambito sanitario.

Man mano che sempre più stati approvano leggi legate all’AI, il carattere frammentato della governance statunitense diventa evidente. Ciò che accomuna molte di queste iniziative, tuttavia, è l’attenzione alle categorie di rischio, alla trasparenza e alla tutela dei consumatori, tutti elementi fortemente enfatizzati nell’AI Act dell’UE.

Sebbene sia improbabile che gli Stati Uniti adottino nel prossimo futuro un quadro centralizzato in stile Bruxelles, l’influenza dell’UE è innegabile. I regolatori e i legislatori americani osservano con attenzione, e le azioni intraprese a livello statale vengono spesso giustificate come un modo per “tenere il passo” con gli standard globali stabiliti dall’Europa.