Uno dei problemi comuni in informatica è quello di tradurre concetti per noi intuitivi in istruzioni per un computer. La grande forza del Deep Learning è stata proprio la capacità delle reti neurali di apprendere da sole cosa fosse importante in una immagine per assegnare un'etichetta (ad es. cane/gatto).

Se infatti ci si ferma a riflettere non è affatto facile specificare per esteso cosa distingue un cane da un gatto, ed è facile trovare controesempi a molte delle caratteristiche che possono sembrarci più intuitive (forma del muso, orecchie a punta, dimensioni).

Questa traduzione si può tentare per tantissimi concetti che adoperiamo tutti i giorni, ma qui ci soffermeremo sul concetto di privacy.

Insegnare la privacy ad un algoritmo

Il concetto di privacy ha varie diramazioni, ed ognuna sicuramente merita di essere approfondita a sé, in questo articolo parleremo della privacy nell’ambito dell’IA e del Machine Learning.

In particolare come possiamo insegnare ad un algoritmo di ML ad essere rispettoso della privacy? E cosa significa rispettare la privacy in ambito IA?

Proviamo prima a rispondere alla seconda domanda: E’ noto da qualche anno che dataset di grandi dimensioni, anche se anonimizzati, possono contenere abbastanza informazioni per risalire all’identità delle persone. Molta ricerca ha mostrato come sia possibile ad esempio partendo da dataset sensibili (ad esempio medici), risalire all’identità delle persone presenti nel dataset.

Sorprendentemente questo problema di privacy non esiste solo per i dataset, che ormai proprio per questi motivi non vengono diffusi pubblicamente (dataset biomedici richiedono di essere dei ricercatori verificati) ma anche per i modelli di ML allenati su questi dataset, da cui è possibile estrarre informazioni sul dataset di allenamento. Questo tipo di tecniche viene chiamato Membership Inference Attack.

Differential Privacy

E’ quindi possibile quantificare quante informazioni si possono estrarre da un dataset o un modello? E come possiamo limitare questa fuga di informazioni?

La Differential Privacy è un approccio matematico che fornisce garanzie formali e quantificabili sulla privacy degli individui presenti in un dataset, per evitare che si possano estrarre informazioni su specifici individui all’interno di un insieme di dati o da un modello.

In pratica la DP introduce una quantità controllata di rumorenelle risposte a query o nell’addestramento dei modelli.

Il rumore serve a rendere ogni interrogazione del dataset o inferenza del modello indistinguibile tra due situazioni: un dataset che contiene uno specifico individuo e uno che invece non lo contiene. Ciò deve valere per ogni persona all’interno del dataset.

Così facendo nessuna proprietà che il dataset o il modello espongono può essere usata per riconoscere un singolo individuo, e grazie a questo approccio è possibile misurare e controllare il livello di privacy.

La Differential Privacy, nella sua forma più semplice, si può adattare usando il parametro ε (epsilon), che misura il "livello di privacy". Valori più bassi indicano maggiore protezione, ma anche più rumore nei dati (con conseguente calo di performance), mentre un parametro più alto indica una minore privacy a favore dell'accuratezza del modello.

Perché è importante?

La Differential Privacy è oggi considerata lo standard di riferimento per la protezione dei dati:

Offre garanzie più forti rispetto alla semplice anonimizzazione, perché consente di misurare e controllare il livello di privacy desiderato. Molte tecniche di anonimizzazione si sono dimostrate inefficaci per dataset sufficientemente grandi

È applicabile a sistemi di machine learning moderni, anche LLM, con un costo (in tempo) aggiuntivo solo in fase di training mentre l’inferenza rimane altrettanto performante.

Aziende come Apple e Google hanno già introdotto DP in prodotti e servizi per raccogliere statistiche d’uso o addestrare modelli in sicurezza: i language model di google che vi suggeriscono le parole sulla tastiera android ad esempio. Anche il census Bureau degli Stati Uniti ha da diversi anni utilizzato tecniche di DP per i dataset che diffonde al pubblico.

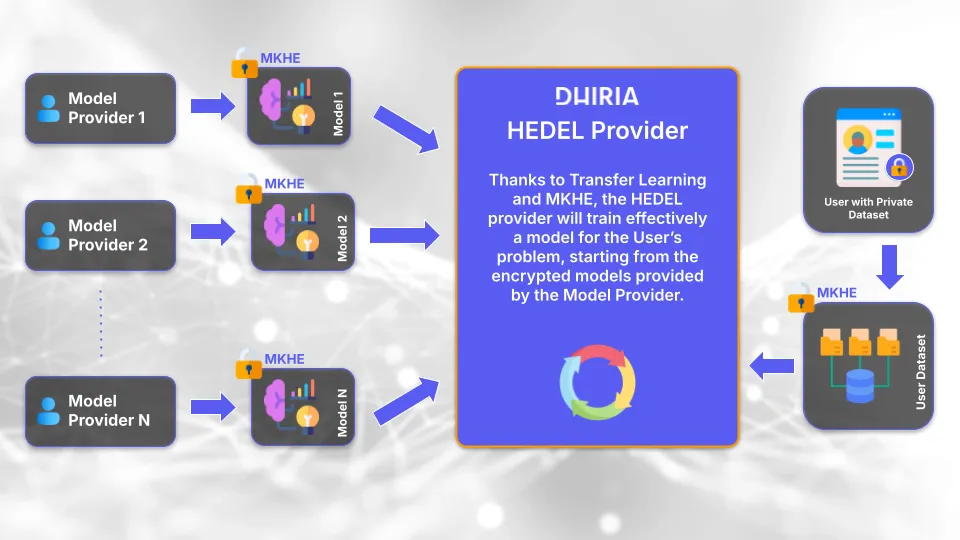

La visione di Dhiria

In Dhiria lavoriamo per rendere l’AI privacy-preserving una realtà concreta. Con soluzioni come la classificazione di testi cifrati e le librerie basate su homomorphic encryption, diamo ai clienti la possibilità di analizzare dati sensibili senza esporli.

Integrare la Differential Privacy in questo contesto significa:

Analisi sicure di dataset sensibili in ambiti come sanità e finanza.

Personalizzazione di modelli con elevate garanzie di sicurezza

La DP non sostituisce la crittografia, ma la completa: da una parte proteggiamo i dati nel loro contenuto, dall’altra tuteliamo la privacy degli individui che quei dati rappresentano.